HBM火了?HBM是什么,你知道嘛?

如果要评选即将过去的2023年的半导体关键词,GPU必然要首先提及的。因为在ChatGPT的推动下,GPU正在过去一年里完成了完美的逆袭,并推动英伟达成为了万亿美元的半导体企业,也使得他们在今年有望成为全球第一的半导体供应商。需要提一句的是,这是一个在过去十多年里几乎都是由英特尔把持的位置,英伟达的登顶,足以见证GPU的魅力。

除此以外,HBM(High Band Memory)也是2023不得不提的一个重点。因为存储市场的千年老二SK海力士凭借这个技术和产品在这个领域实现了对三星的完胜。同时还为未来的继续发展挣下了足够的筹码。

市场分析机构Omdia也预计,在人工智能大模型的推动下,未来几年,HBM的需求将继续超过供应。他们提供的数据显示,从2023年到2027年,DRAM市场收入的年增长率预计为21%,而HBM市场预计将飙升52%。HBM在DRAM市场收入中的份额预计也将从今年的不超过10%增长到2027年将接近20%。

HBM,恰逢其时

那么,HBM

高带宽存储器

早在2008年,AMD就开始着手研发高带宽存储器来解决日益增长的能源使用及计算机内存的形状因数。其中,AMD高级研究员Bryan Black解决了裸晶堆叠问题。AMD还从内存行业(SK海力士)、中介层行业(联华电子)及封装行业(日月光半导体)的合作伙伴中获得了帮助,让高带宽存储器从设想变成现实。

到了2013年10月,JEDEC就将高带宽存储器正式采纳为业界标准。2015年,SK海力士在韩国利川市的工厂正式开始量产HBM。直到人工智能、生成式人工智能的火热,市场对训练数据的需求量暴增,于是英伟达等厂商就将HBM引入到相关产品,从而引爆了HBM的使用潮。

从相关报道我们也能看到,自2012年以来,大规模的AI训练所使用的数据集的计算量是以每年10倍的速度在增长。以推出大家所熟知的ChatGPT的OpenAI公司为例,在2022年11月推出的ChatGPT版本中,他们使用了1750亿个参数。到了今年3月的版本中,他们使用的参数则是达到1.5万亿个。

之所以发生这样的转变,其中背后的原因有以下三点:第一,AI模型变得日益复杂了;第二,有大量的数据在线被生成,而且可以被使用在AI训练过程中去;第三,这些人工智能的应用对于准确性和稳健性的期望也在持续提升。以上这些需求转化为对内存的需求,实际上就意味着需要更高带宽和更高容量。

这就带来了HBM的第二春。

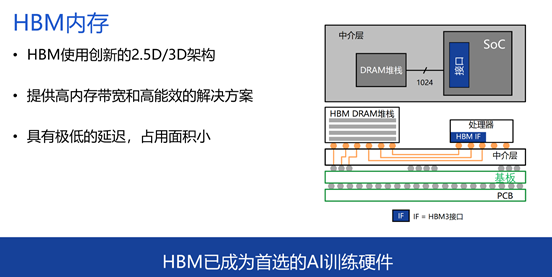

据Rambus 接口IP产品管理和营销副总裁 Joe Salvador先生介绍,高带宽内存(HBM)包含了中介层,以及处理器、内存堆栈。这就意味着我们可以通过HBM带来非常高的带宽,而且还有非常高的能效解决方案,及低延迟。正是由于以上的这些原因,HBM已经成为了目前首选的AI训练硬件。

如上图所示,在过去多年的发展中,HBM进行了多代的更新,不断地提升速度,以满足终端市场的需求。

总的来说

注:文章整理转载于网络,仅供参考学习,版权归原作者所有,如涉及侵权,请联系小编删除。

Pre:台积电发力1nm工艺,力争2030年打造1万亿晶体管芯片 2025-12-30

Next:浅析工业机器人传感器类型和应用场景 2025-12-30

Collect

Collect

Navigate:

Navigate: